9 月 29 日消息,当用户提交情感化或个性化提示词时,OpenAI 旗下的 ChatGPT 会自动切换到限制性更强的语言模型,但这一过程不会通知用户。

目前,OpenAI 正在 ChatGPT 中测试一款全新的“安全路由系统”,该系统可根据对话主题自动将交流内容导向不同模型。ChatGPT 负责人尼克・特利(Nick Turley)表示,只要对话涉及“敏感或情感类主题”,该系统就会启动干预。

在实际应用中,ChatGPT 会将用户提示词临时转交至更严格的模型进行处理,例如 GPT-5,或是专用模型“gpt-5-chat-safety”。特利指出,这种模型切换仅针对单条消息触发,且只有当用户专门就此向模型提问时,切换行为才会显露出痕迹。

据悉,OpenAI 早在 9 月的一篇博客文章中就首次披露了这类基于情感的路由机制,并将其描述为针对“严重心理困扰”场景的防护措施。而特利此次的最新表态则将该机制的适用范围扩大到所有涉及敏感或情感领域的对话。

莱克斯(Lex)对这套新路由系统开展的技术评估显示,即便是无害的情感化或个性化提示词,也常常会被重定向至更严格的“gpt-5-chat-safety”模型。此外,涉及模型自身角色设定或其“自我认知”的提示词,同样会触发自动切换。

已有一名用户记录下了模型切换的实际过程,其他用户也证实了类似情况的存在。目前似乎还存在第二款路由模型“gpt-5-a-t-mini”,当用户提示词可能涉及请求实施潜在非法行为时,该模型便会被启用。(新闻来源:IT之家)

商务合作:13146398132

媒体合作:13341147250

爆料投稿:editor@vrarworld.cn

版权声明:本文为VRAR星球原创,任何单位及个人未经授权不得转载,否则将依法追究侵权责任。

如需转载请联系13341147250 / editor@vrarworld.cn 申请授权,转载时请注明来源并保留VRAR星球原文链接。

本文部分图片及视频来源于互联网,如涉及侵权请联系我们删除。

肯尼亚外包工揭露Meta智能眼镜数据内幕:让你的日常生活彻底“裸奔”

雷鸟创新携手德国电信亮相MWC 2026,推出首款代理式AI智能眼镜

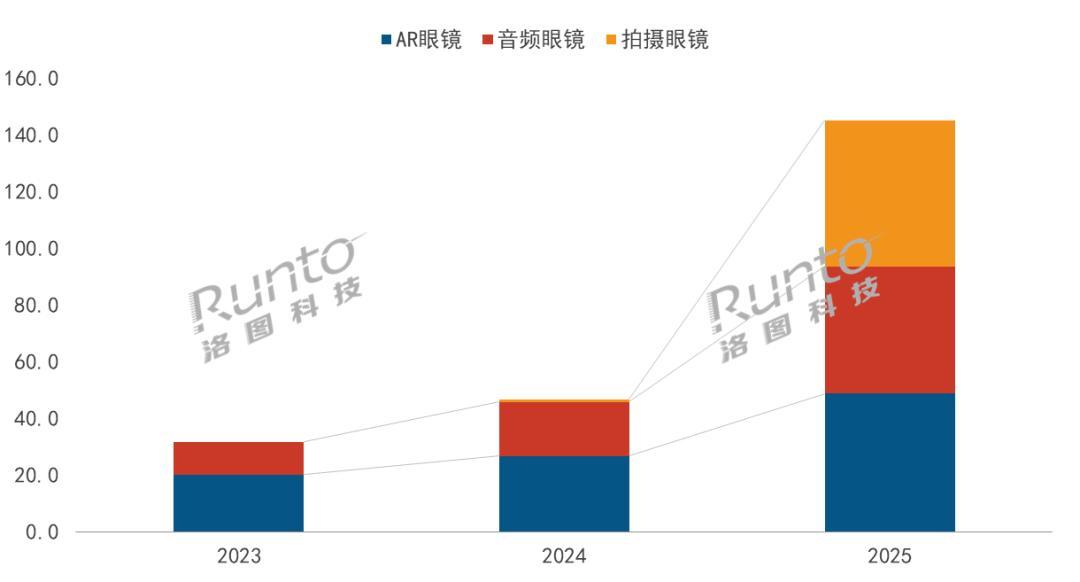

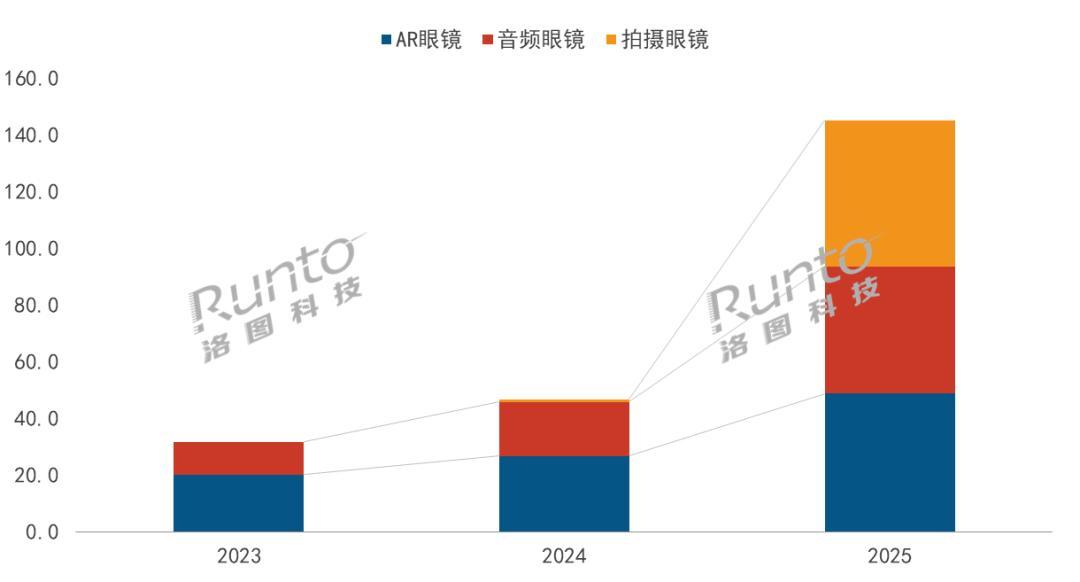

2025年中国智能眼镜市场的销量为145.4万台,同比大涨211%

听过却没体验过?XR产品距离“破圈”还差一次亲手触碰

鲸鸣视控推出A控儿童智能眼镜·芯生代系列,以AI科技助力儿童视力健康主动管理

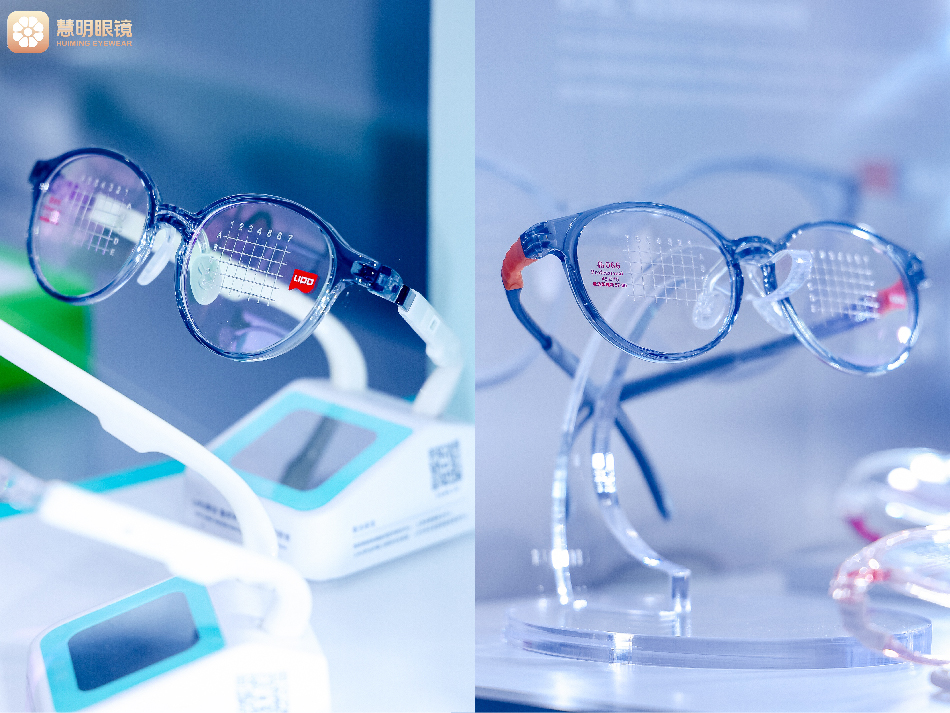

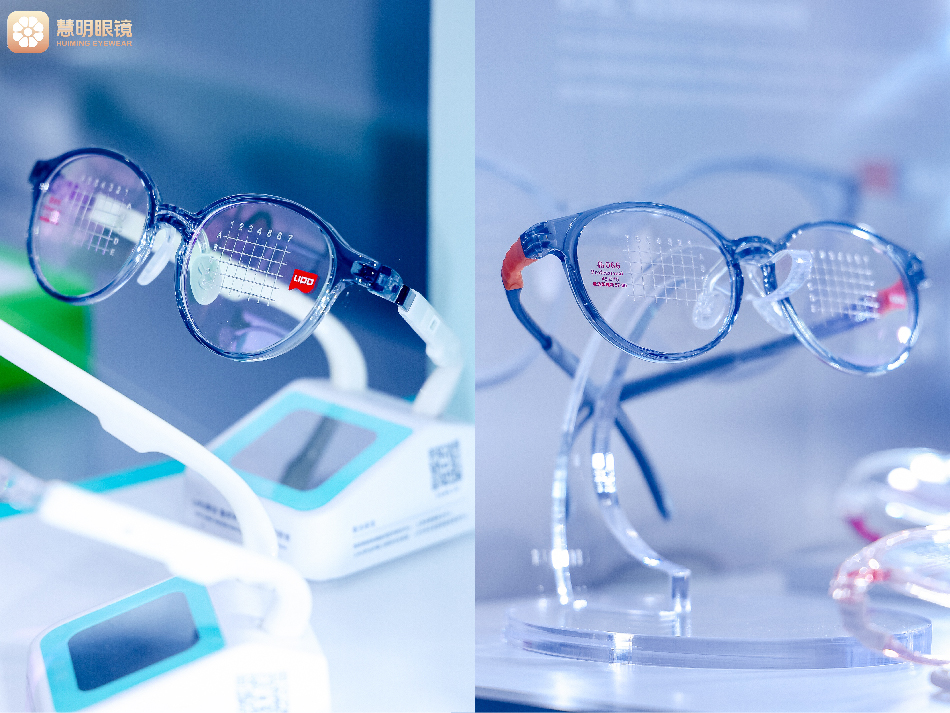

慧明眼镜集团首发人工智能配镜终端,向全球展示未来视光服务“中国方案”

北京同创蓝天云科技推出“酷雷曼VR内容一体机”

《Beat Saber》加入Horizon Plus订阅服务,但DLC仍需付费购买

Meta首席技术官:VR游戏“摇钱树”时代已经结束,客户获取才是真正的难题

肯尼亚外包工揭露Meta智能眼镜数据内幕:让你的日常生活彻底“裸奔”

雷鸟创新携手德国电信亮相MWC 2026,推出首款代理式AI智能眼镜

2025年中国智能眼镜市场的销量为145.4万台,同比大涨211%

鲸鸣视控推出A控儿童智能眼镜·芯生代系列,以AI科技助力儿童视力健康主动管理

慧明眼镜集团首发人工智能配镜终端,向全球展示未来视光服务“中国方案”

北京同创蓝天云科技推出“酷雷曼VR内容一体机”

《Beat Saber》加入Horizon Plus订阅服务,但DLC仍需付费购买

Meta首席技术官:VR游戏“摇钱树”时代已经结束,客户获取才是真正的难题

北京市门头沟区发布AI+微短剧三年行动计划,XR沉浸视听联合实验室揭牌